21 октября 2021 giovanni1313

Продолжаем знакомиться с отчетом о состоянии дел в области искусственного интеллекта ”AI100”. Сегодняшняя тема — опасности, исходящие от ИИ. Тема более чем интересная; вдобавок, экспертам предложили выделить не просто теоретические, «абстрактные» опасности — но наиболее актуальные, острые угрозы. И, забегая вперед, выбранные ими опасности рисуют весьма любопытную картину…

1. Техно-солюционизм

Чего, по мнению экспертов, стоит остерегаться больше всего? Первая угроза — техно-солюционизм. Это относительно новая концепция, согласно которой для абсолютно любой проблемы можно найти технологическое решение. Термин чаще употребляется противниками такой идеи. Они критикуют такой подход, упирая на то, что он часто граничит с наивностью и пренебрежением к глубоким корням решаемых проблем.

Аналогичный взгляд мы видим и у авторов ”AI100”. Они боятся, что ИИ воспринмается в качестве панацеи, хотя на самом деле он является всего лишь инструментом. «Технологии часто создают бОльшие проблемы в процессе решения меньших», — предупреждают они.

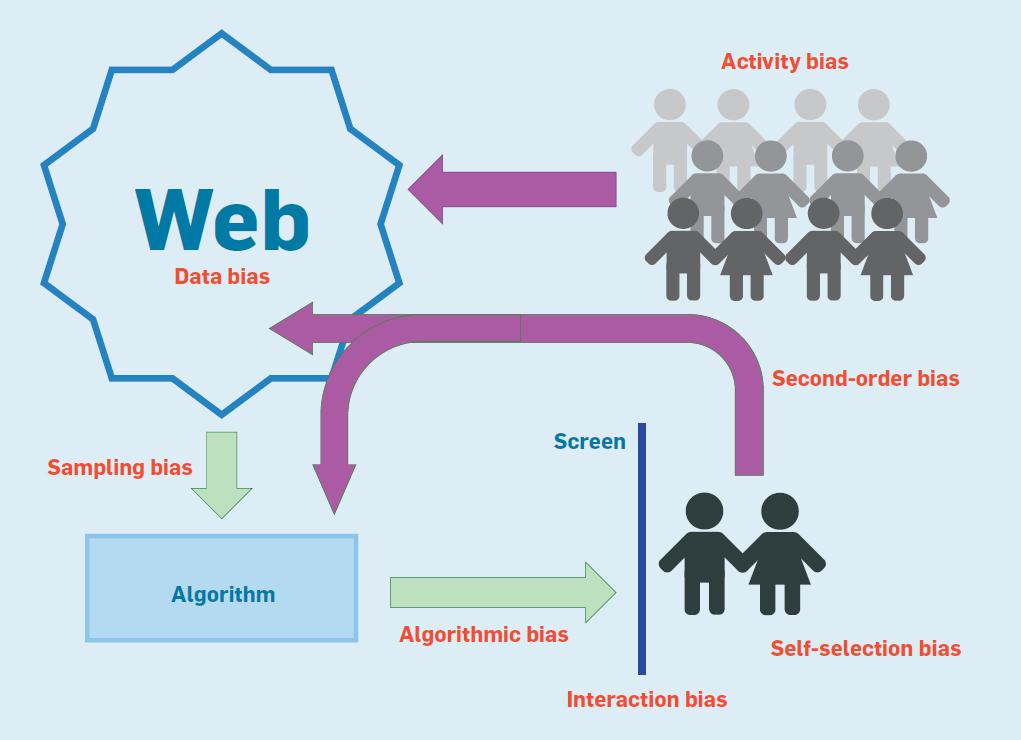

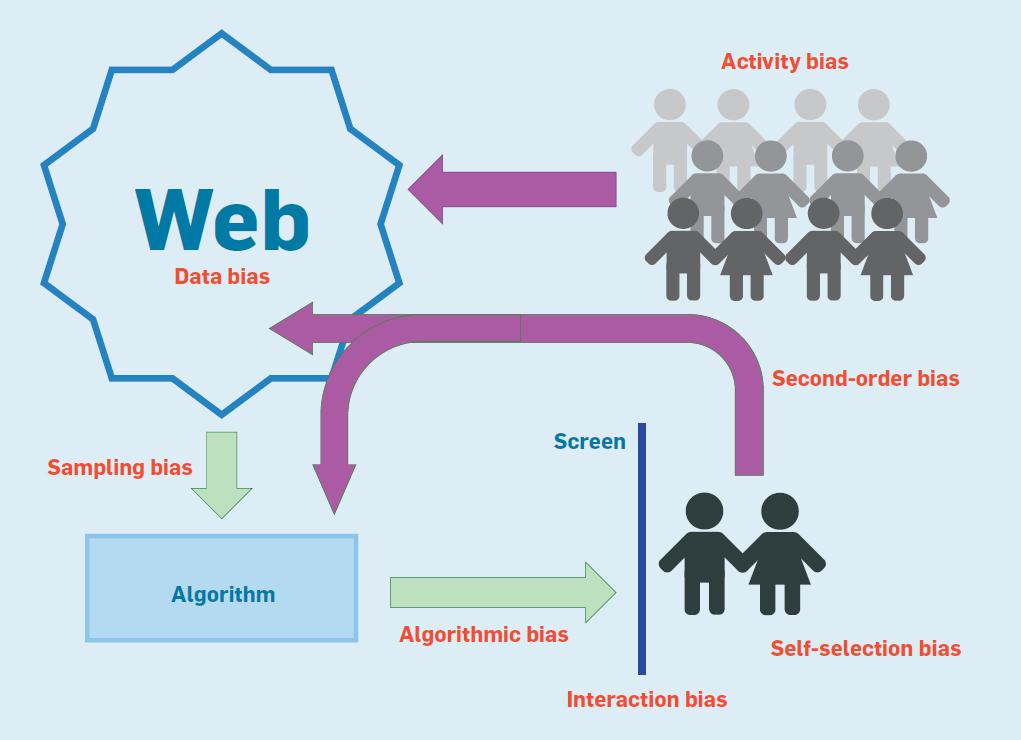

Эксперты отмечают, что некоторые верят, будто при сравнении алгоритмов и людей алгоритмы всегда будут менее подвержены предубеждениям. Но это, увы, не так. Одно из ключевых противоречий — фактическая мотивация разработчиков таких алгоритмов, которая несет на себе глубокий отпечаток существующих практик и преобладающего порядка вещей. «Поскольку любая технология является продуктом необъективной системы, корни недостатков техно-солюционизма лежат глубоко: творение ограничено ограниченностью своего творца».

Подчеркивая инструментальный характер ИИ, ”AI100” пугает читателя совсем уж антиутопическими тезисами: «Автоматизированное принятие решений часто может служить воспроизведению, осложнению и даже усилению тех же самых предубеждений, которые мы надеемся исправить с его помощью».

Тут возникает вопрос: много ли мы знаем других технологий, которые систематически давали бы эффект, противоположный желаемому? И действительно ли с ИИ это случается так часто — чаще, чем позитивный эффект? ”AI100” не утруждает себя убедительной аргументацией. Но подобные страшилки противоречат даже тезису, который подчеркивается в одной из предыдущих глав отчета: никакого технологического детерминизма не существует, и ИИ будет работать так, как у создателей получится его спроектировать.

И тогда возникает закономерный вопрос: зачем создателям система, умножающая несправедливость? Если мы всерьез обсуждаем такие тенденции, более того — считаем их наиболее актуальной угрозой, честное слово, ИИ — далеко не самая насущная наша проблема.

Поневоле начинаешь задумываться: в угаре борьбы с техно-солюционизмом не ударяются ли авторы в другую крайность, технопессимизм? И не является ли эта беспочвенная ИИ-фобия, негативный имидж не меньшей угрозой для общества?

2. Опасность принятия статистического взгляда на справедливость

Следующий риск во многом связан с предыдущим. Что под ним имеется в виду?

Дело в том, что общество может воспринять решения ИИ-алгоритмов как безусловную истину. «В некоторых уголках общественного сознания с решениями ИИ связана аура нейтральности и беспристрастности, и в результате системы считаются объективными, хотя они могут быть результатом пристрастных исторических решений или даже грубой дискриминации».

В дополнение к этому публика не слишком хорошо воспринимает понятие неопределенности. Алгоритмическая оценка, имеющая вероятностный характер, может ошибочно восприниматься как факт. Причем не только обществом, но и судебной системой, которая выносит судьбоносные для человека вердикты.

«Решения по уголовным делам всё больше выносятся проприетарными алгоритмами […], что вызывает тревогу о том, что правосудие передается в ведение программного обеспечения... Нет гарантий, что люди, использующие эти прогнозы, распорядятся с ними рациональным образом». Другими словами, риск заключается в том, что ответственные лица банально не умеют работать с новыми инструментами, и их невежество может свести на нет все преимущества ИИ.

«Если считать вероятность определенностью, то прошлое всегда будет диктовать будущее», — отмечают авторы. Ирония, которую они совершенно упускают из вида — именно так, с определенностью вердиктов и использованием исключительно прошлых событий, и работает современная «человеческая» судебная система. Пресловутый статистический взгляд, который ”AI100” называет опасностью, на деле предлагает гораздо более богатые, вероятностные трактовки и рекомендации. Трактовки, которые гораздо ближе к истине. Истинная опасность, таким образом, исходит не от передачи правосудия алгоритмам, а от «людей-в-системе» (human-in-the-loop), которые из-за скудоумия грозят обратить это богатство во вред обществу.

Еще одну проблему представляют предубеждения, заложенные в алгоритмы. Причем она усугубляется непрозрачностью используемых технологий. Кроме того, авторы предостерегают об использовании замещающих признаков — «номинально невинных атрибутов, которые позволяют принять фундаментально пристрастное решение».

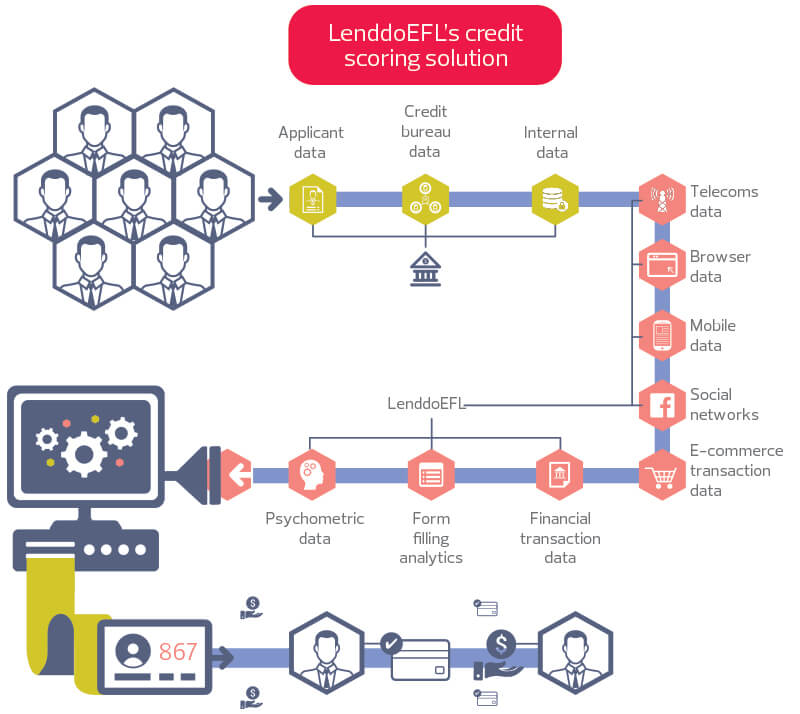

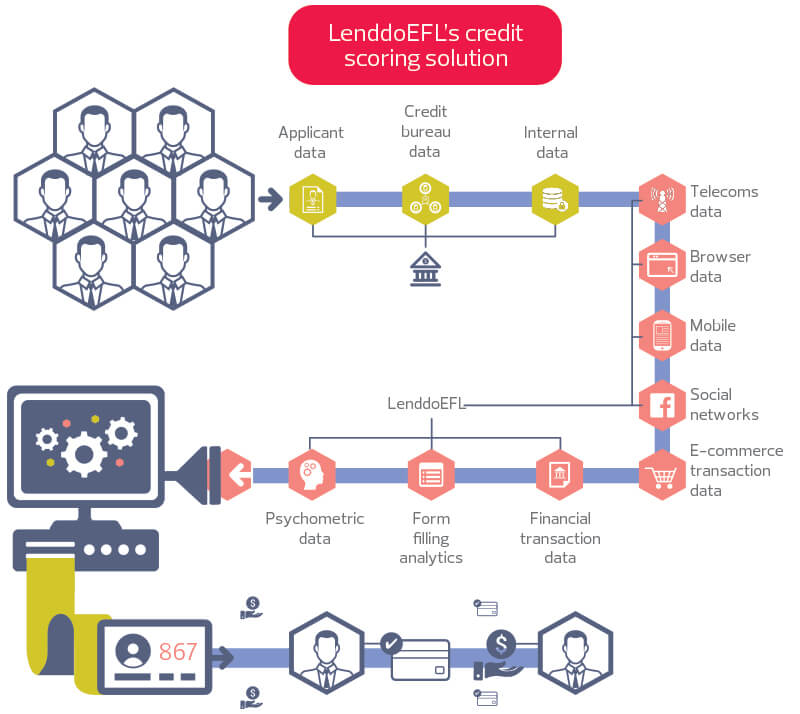

Что это за признаки? ”AI100” приводит следующий пример. «Среди европейцев была показана статистически значимая корреляция между кредитным риском и тем, использует ли человек «Макинтош» или ПК, а также включают ли они своё имя в адрес e-mail – что оказалось аналогами уровня достатка. Компании, использующие такие аттрибуты, даже если они действительно обеспечивают улучшение точности модели, могут нарушать закон, когда эти атрибуты также четко коррелируют с защищенной категорией вроде расы».

Поскольку в наш век больших данных можно найти великое множество подобных атрибутов, коррелирующих со всеми возможными защищенными категориями, возникает интересная коллизия. Получается, нам не нужна точность. Этот момент хочется выделить особенно сильно. Дело в том, что современные модели ИИ основаны на статистических принципах, и точность является первым и главным критерием его работы.

Другими словами, с точки зрения технологии, хороший ИИ = точный ИИ. Но не с точки зрения правового поля. С точки зрения правового поля хороший ИИ = ...нет, даже не справедливый ИИ. Справедливость в работе ИИ означает, что он одинаково часто и в одинаковую сторону ошибается для всех категорий: рас, полов, возрастов и т. д.

Пожалуй, соответствующий законодательству ИИ стоит назвать «уравнительным»: он даёт одинаковый шанс всем представителям защищенных категорий безотносительно того, что говорят реальные данные. Эти реальные данные и формируют статистику, взгляд со стороны которой — опять обратим на это внимание — авторы ”AI100” считают опасным. Проблема в том, что при разработке ИИ, кроме как на статистику, опираться больше не на что. Как бы красиво ни звучали общественные идеалы равенства и братства, они нисколько не помогут в практике создания более мощных технологий ИИ.

Более того, сам тезис о несовместимости статистических подходов и справедливости видится весьма шатким. Каким образом мы можем прийти к справедливому состоянию, если мы не будем обрабатывать имеющиеся данные? Более того, мы даже не сможем знать, насколько справедливым наше общество является сейчас.

Ближайшим смысловым эквивалентом статистического подхода будет «математически строгий» или «научный». Противопоставить ему можно индивидуальный подход — субъективный, волюнтаристский. Этого ли хотят авторы ”AI100”?

Возможно, им кажется, что персональные предубеждения — это незначительное зло, а проблемы системных предубеждений не существует вовсе? Тогда я их разочарую: подавляющее большинство специалистов считают, что проблема реальна, более того — она гораздо более опасна для общества, чем индивидуальные пристрастия.

А с системными проблемами надо бороться системно. И на этом пути не обойтись без беспристрастного алгоритмического агрегирования и анализа больших данных. Искусственный интеллект является наиболее мощным инструментом для обработки сложных массивов данных. Соответственно использование таких систем является не просто желаемым, но даже необходимым средством достижения справедливости в обществе.

Косвенно с этим соглашаются и авторы. «Без прозрачности как в данных, так и в алгоритмах ИИ, интерпретирующих их, общество может оставаться в неведении относительно того, как принимаются решения, серьезно влияющие на их жизнь». Эта прозрачность сейчас отсутствует в человеческих системах принятия решений. Алгоритмизация — пожалуй, наиболее надежный способ сделать такие системы прозрачнее. А также устойчивее, объективнее и точнее. Слепая вера в силу алгоритмов опасна — но рациональное зерно в ней, безусловно, есть.

3. Дезинформация и угроза демократии

”AI100” лишь мимоходом касается этой темы. Какие роли здесь может играть ИИ? Отчет называет два варианта: дипфейки и онлайн-боты, имитирующие консенсус по какому-либо вопросу и распространяющие фейковые новости.

Еще одним поводом для беспокойства (который авторы почему-то запихнули в предыдущий риск) являются создаваемые ИИ в цифровых медиа «информационные пузыри», сужающие набор доступных индивиду точек зрения. Осведомленность и возможность взвешенного выбора являются важными предпосылками для эффективных демократических процессов.

В целом ”AI100” не слишком глубоко погружается в тему влияния ИИ на политику, хотя потенциально спектр влияния новой технологии здесь очень широк. Возможно, авторы считают, что для серьезного вклада многие потенциальные изменения еще не дозрели. ”AI100” сосредоточен на дезинформации — феномене, касающемся далеко не только ИИ, и в рамках которого более традиционные игроки продолжают играть преобладающую роль.

Но один из тезисов достоин внимания. «Споры вокруг того, что реально, быстро превращаются в споры о том, кто решает, что реально, а что — нет. Итогом этого является пересмотр структур власти, часто служащих устоявшимся интересам». Действительно, всё большую роль сейчас играет онлайн-авторитет. И он медленно, но верно отвоевывает силу как у традиционных государственных структур, так и у «четвертой власти» — СМИ. Всё это весьма интересно с точки зрения эволюции демократии.

4. Риск дискриминации и ошибок в медицине

Машинные модели уже широко распространены в сфере здравоохранения. Но у них есть так и не решенная проблема: они плохо генерализуются за пределами обучающих данных. Другими словами, даже минимальные отличия клинической практики от тех данных, что были использованы для обучения систем, способны сильно снизить точность модели.

Ситуация усугубляется тем, что «врачи и администраторы плохо подготовлены к отслеживанию и борьбе с такими проблемами, и недостаточный учет человеческого фактора при интеграции ИИ приводит к колебаниям между недоверием к системе (игнорированием ее) и избыточной уверенностью в ней (доверием даже тогда, когда она не права)...» Отсылка к человеческому фактору повторяет то, что было сказано в контексте применения ИИ в правосудии: человеческое невежество способно обратить во вред даже самую эффективную технологию.

Но и на этапе создания модели ошибки тоже возможны. А цена ошибки в сфере здравоохранения велика. «Неправильно обученный алгоритм может причинить больше вреда, чем пользы для подверженных риску пациентов.

Авторы не упускают случая в очередной раз напомнить читателю про опасности предубеждений, закрепленных в моделях. В качестве примера они приводят историю с американской ”Optum”, чей алгоритм сильно занижал уровень медицинских рисков для чернокожих пациентов по сравнению с белыми. Загвоздка была в том, что система использовала прогноз будущих медицинских расходов в качестве меры риска. А у чернокожего населения США они на $1,8 тыс. долларов в год ниже, чем у белых.

То есть оцените степень лицемерия: здравоохранение фактически тратит на негров существенно меньше денег, чем на белых — но виноват почему-то оказался алгоритм. Конечно, проще бороться со следствием, чем с причиной. И это не просто расхожая фраза: исправить алгоритм на самом деле оказалось очень легко.

Но это не останавливает пыл авторов. «...Индивиды, исключенные из изначальных датасетов, не получат адекватного внимания». Стоп, как это должно работать?! Эксперты не в курсе, что алгоритмы обучаются на ограниченной выборке — запихнуть в обучающий датасет всё население попросту невозможно? Более того, в медицинских применениях почти всё зависит от конкретного времени: потребности пациента за 10 лет до инсульта сильно отличаются от потребностей через 30 минут после, и даже к абсолютно здоровому человеку в 5-летнем возрасте медицина относится совсем по-иному, чем в 80-летнем. Добавим, что на ограниченных выборках проверяются и все виды классической терапии. В чем тогда заключается претензия ”AI100”?

Но это не всё. Еще большее удивление вызывает следующий пассаж. «...Потенциал [алгоритмов] по воспроизведению пристрастий означает, что любой прогресс, который они принесут для населения в целом — от диагностики до распределения ресурсов — может быть достигнут за счет наиболее уязвимых [групп]”.

Ну хорошо, распределение ресурсов еще можно представить как игру с нулевой суммой. Но всё остальное? И даже с ресурсами не все так однозначно — возможность ИИ расширить пул доступных ресурсов тоже нельзя сбрасывать со счетов.

И это мы еще не касались вопроса, насколько алгоритмы воспроизводят пристрастия лучше, чем человеческие системы. И действительно ли они более склонны обижать уязвимые слои населения — слои, которые стали уязвимыми исключительно по итогам работы человеческих институтов.

Мы уже упоминали про технологический детерминизм — а что насчет детерминизма институционального? Или авторы реально считают, что в человеческих институтах нет системных предубеждений, которые воспроизводят сами себя? Альтернативные варианты — это важная часть оценки любого риска. Увы, авторы ”AI100” напрочь игнорируют эту часть.

Выводы

Подведем итоги. Первая, и очень важная тема, которая объединяет почти все перечисленные выше риски — это то, что источником проблем является даже не столько сам ИИ, сколько работающие с ним люди. Те, кто не до конца понимает его возможности и ограничения, те, кто не умеет с ним работать, те, чьи наивные представления сильно расходятся с реальным состоянием дел. Пресловутый человеческий фактор оказывается самым слабым звеном при внедрении ИИ в практику.

И решения здесь лежат скорее не в плоскости улучшения ИИ, а в повышении ИИ-грамотности, образовательных усилиях и тщательном дизайне обращенной к пользователю части системы.

Второе наблюдение — эксперты придают огромнейшее значение вопросам справедливости. Едва ли не каждая тема насыщена упоминаниями о том, насколько алгоритмы пристрастны и насколько это опасно. Всё это ложится в русло восприятия прогресса в ИИ как игры с нулевой суммой (хотя прямо авторы это не утверждают): суммарная польза (или вред, поскольку глава исследует риски) несущественны; всё, на что способен ИИ — это угнетать уязвимые группы и возвышать за счет них привилегированные.

Такое пренебрежение общими эффектами в пользу особенностей их распределения выглядит странно как минимум на фоне того, что ИИ считается подрывной технологией, т. е. способной фундаментально изменить жизнь людей. Трудно согласиться с позицией, что нас не волнует, будем ли мы жить хорошо или плохо — главное, чтобы всем было одинаково хорошо или плохо...

При этом у меня сложилось впечатление, что эксперты довольно узко трактуют алгоритмические пристрастия, делая акцент на мейнстримных категориях — раса, пол, уровень дохода, наличие инвалидности. С одной стороны, сейчас действительно у маргинализованных групп этих категорий хватает проблем. Но, с другой, использование новых инструментов может повлечь за собой возникновение новых проблемных категорий, да и не все из существующих уязвимых групп получают внимание мейнстримных экспертов и медиа. В целом, немного перефразировав известное изречение, слова авторов ”AI100” об ИИ говорят нам больше об авторах ”AI100”, чем об ИИ.

Наконец, еще один момент — довольно скромный набор потенциальных рисков, предложенных экспертами. Без внимания остались некоторые вещи, где внимание было бы очень кстати. Подрывной характер технологии и весьма быстрое ее распространение означают, что крупные изменения затрагивают очень многие стороны нашей жизни.

Два направления хотелось бы отметить особо. Первое — боевое применение ИИ. ”AI100” упоминает его совсем мельком, в другой главе. Между тем, со времени публикации предыдущего отчета произошло эпохальное событие — впервые в истории человечества автономная машина выследила и убила людей. Технологии автономии стали настолько зрелыми и доступными, что в ближайшие пять лет нас ждет буквально «взрыв» количества развернутых боевых ИИ-систем.

Второе — это алгоритмизация систем принятия решений, проводимая коммерческими компаниями. Самые различные вещи, которые раньше были заботой людей — поиск романтического партнера, подбор лечения, отбор поступающих в учебные заведения — сейчас выполняется при помощи коммерческих алгоритмов. Их создатели преследуют коммерческие интересы — и рост влияния капитала в прежде "гуманитарных" сферах может создать опасные коллизии.

1. Техно-солюционизм

Чего, по мнению экспертов, стоит остерегаться больше всего? Первая угроза — техно-солюционизм. Это относительно новая концепция, согласно которой для абсолютно любой проблемы можно найти технологическое решение. Термин чаще употребляется противниками такой идеи. Они критикуют такой подход, упирая на то, что он часто граничит с наивностью и пренебрежением к глубоким корням решаемых проблем.

Аналогичный взгляд мы видим и у авторов ”AI100”. Они боятся, что ИИ воспринмается в качестве панацеи, хотя на самом деле он является всего лишь инструментом. «Технологии часто создают бОльшие проблемы в процессе решения меньших», — предупреждают они.

Эксперты отмечают, что некоторые верят, будто при сравнении алгоритмов и людей алгоритмы всегда будут менее подвержены предубеждениям. Но это, увы, не так. Одно из ключевых противоречий — фактическая мотивация разработчиков таких алгоритмов, которая несет на себе глубокий отпечаток существующих практик и преобладающего порядка вещей. «Поскольку любая технология является продуктом необъективной системы, корни недостатков техно-солюционизма лежат глубоко: творение ограничено ограниченностью своего творца».

Подчеркивая инструментальный характер ИИ, ”AI100” пугает читателя совсем уж антиутопическими тезисами: «Автоматизированное принятие решений часто может служить воспроизведению, осложнению и даже усилению тех же самых предубеждений, которые мы надеемся исправить с его помощью».

Тут возникает вопрос: много ли мы знаем других технологий, которые систематически давали бы эффект, противоположный желаемому? И действительно ли с ИИ это случается так часто — чаще, чем позитивный эффект? ”AI100” не утруждает себя убедительной аргументацией. Но подобные страшилки противоречат даже тезису, который подчеркивается в одной из предыдущих глав отчета: никакого технологического детерминизма не существует, и ИИ будет работать так, как у создателей получится его спроектировать.

И тогда возникает закономерный вопрос: зачем создателям система, умножающая несправедливость? Если мы всерьез обсуждаем такие тенденции, более того — считаем их наиболее актуальной угрозой, честное слово, ИИ — далеко не самая насущная наша проблема.

Поневоле начинаешь задумываться: в угаре борьбы с техно-солюционизмом не ударяются ли авторы в другую крайность, технопессимизм? И не является ли эта беспочвенная ИИ-фобия, негативный имидж не меньшей угрозой для общества?

2. Опасность принятия статистического взгляда на справедливость

Следующий риск во многом связан с предыдущим. Что под ним имеется в виду?

Дело в том, что общество может воспринять решения ИИ-алгоритмов как безусловную истину. «В некоторых уголках общественного сознания с решениями ИИ связана аура нейтральности и беспристрастности, и в результате системы считаются объективными, хотя они могут быть результатом пристрастных исторических решений или даже грубой дискриминации».

В дополнение к этому публика не слишком хорошо воспринимает понятие неопределенности. Алгоритмическая оценка, имеющая вероятностный характер, может ошибочно восприниматься как факт. Причем не только обществом, но и судебной системой, которая выносит судьбоносные для человека вердикты.

«Решения по уголовным делам всё больше выносятся проприетарными алгоритмами […], что вызывает тревогу о том, что правосудие передается в ведение программного обеспечения... Нет гарантий, что люди, использующие эти прогнозы, распорядятся с ними рациональным образом». Другими словами, риск заключается в том, что ответственные лица банально не умеют работать с новыми инструментами, и их невежество может свести на нет все преимущества ИИ.

«Если считать вероятность определенностью, то прошлое всегда будет диктовать будущее», — отмечают авторы. Ирония, которую они совершенно упускают из вида — именно так, с определенностью вердиктов и использованием исключительно прошлых событий, и работает современная «человеческая» судебная система. Пресловутый статистический взгляд, который ”AI100” называет опасностью, на деле предлагает гораздо более богатые, вероятностные трактовки и рекомендации. Трактовки, которые гораздо ближе к истине. Истинная опасность, таким образом, исходит не от передачи правосудия алгоритмам, а от «людей-в-системе» (human-in-the-loop), которые из-за скудоумия грозят обратить это богатство во вред обществу.

Еще одну проблему представляют предубеждения, заложенные в алгоритмы. Причем она усугубляется непрозрачностью используемых технологий. Кроме того, авторы предостерегают об использовании замещающих признаков — «номинально невинных атрибутов, которые позволяют принять фундаментально пристрастное решение».

Что это за признаки? ”AI100” приводит следующий пример. «Среди европейцев была показана статистически значимая корреляция между кредитным риском и тем, использует ли человек «Макинтош» или ПК, а также включают ли они своё имя в адрес e-mail – что оказалось аналогами уровня достатка. Компании, использующие такие аттрибуты, даже если они действительно обеспечивают улучшение точности модели, могут нарушать закон, когда эти атрибуты также четко коррелируют с защищенной категорией вроде расы».

Поскольку в наш век больших данных можно найти великое множество подобных атрибутов, коррелирующих со всеми возможными защищенными категориями, возникает интересная коллизия. Получается, нам не нужна точность. Этот момент хочется выделить особенно сильно. Дело в том, что современные модели ИИ основаны на статистических принципах, и точность является первым и главным критерием его работы.

Другими словами, с точки зрения технологии, хороший ИИ = точный ИИ. Но не с точки зрения правового поля. С точки зрения правового поля хороший ИИ = ...нет, даже не справедливый ИИ. Справедливость в работе ИИ означает, что он одинаково часто и в одинаковую сторону ошибается для всех категорий: рас, полов, возрастов и т. д.

Пожалуй, соответствующий законодательству ИИ стоит назвать «уравнительным»: он даёт одинаковый шанс всем представителям защищенных категорий безотносительно того, что говорят реальные данные. Эти реальные данные и формируют статистику, взгляд со стороны которой — опять обратим на это внимание — авторы ”AI100” считают опасным. Проблема в том, что при разработке ИИ, кроме как на статистику, опираться больше не на что. Как бы красиво ни звучали общественные идеалы равенства и братства, они нисколько не помогут в практике создания более мощных технологий ИИ.

Более того, сам тезис о несовместимости статистических подходов и справедливости видится весьма шатким. Каким образом мы можем прийти к справедливому состоянию, если мы не будем обрабатывать имеющиеся данные? Более того, мы даже не сможем знать, насколько справедливым наше общество является сейчас.

Ближайшим смысловым эквивалентом статистического подхода будет «математически строгий» или «научный». Противопоставить ему можно индивидуальный подход — субъективный, волюнтаристский. Этого ли хотят авторы ”AI100”?

Возможно, им кажется, что персональные предубеждения — это незначительное зло, а проблемы системных предубеждений не существует вовсе? Тогда я их разочарую: подавляющее большинство специалистов считают, что проблема реальна, более того — она гораздо более опасна для общества, чем индивидуальные пристрастия.

А с системными проблемами надо бороться системно. И на этом пути не обойтись без беспристрастного алгоритмического агрегирования и анализа больших данных. Искусственный интеллект является наиболее мощным инструментом для обработки сложных массивов данных. Соответственно использование таких систем является не просто желаемым, но даже необходимым средством достижения справедливости в обществе.

Косвенно с этим соглашаются и авторы. «Без прозрачности как в данных, так и в алгоритмах ИИ, интерпретирующих их, общество может оставаться в неведении относительно того, как принимаются решения, серьезно влияющие на их жизнь». Эта прозрачность сейчас отсутствует в человеческих системах принятия решений. Алгоритмизация — пожалуй, наиболее надежный способ сделать такие системы прозрачнее. А также устойчивее, объективнее и точнее. Слепая вера в силу алгоритмов опасна — но рациональное зерно в ней, безусловно, есть.

3. Дезинформация и угроза демократии

”AI100” лишь мимоходом касается этой темы. Какие роли здесь может играть ИИ? Отчет называет два варианта: дипфейки и онлайн-боты, имитирующие консенсус по какому-либо вопросу и распространяющие фейковые новости.

Еще одним поводом для беспокойства (который авторы почему-то запихнули в предыдущий риск) являются создаваемые ИИ в цифровых медиа «информационные пузыри», сужающие набор доступных индивиду точек зрения. Осведомленность и возможность взвешенного выбора являются важными предпосылками для эффективных демократических процессов.

В целом ”AI100” не слишком глубоко погружается в тему влияния ИИ на политику, хотя потенциально спектр влияния новой технологии здесь очень широк. Возможно, авторы считают, что для серьезного вклада многие потенциальные изменения еще не дозрели. ”AI100” сосредоточен на дезинформации — феномене, касающемся далеко не только ИИ, и в рамках которого более традиционные игроки продолжают играть преобладающую роль.

Но один из тезисов достоин внимания. «Споры вокруг того, что реально, быстро превращаются в споры о том, кто решает, что реально, а что — нет. Итогом этого является пересмотр структур власти, часто служащих устоявшимся интересам». Действительно, всё большую роль сейчас играет онлайн-авторитет. И он медленно, но верно отвоевывает силу как у традиционных государственных структур, так и у «четвертой власти» — СМИ. Всё это весьма интересно с точки зрения эволюции демократии.

4. Риск дискриминации и ошибок в медицине

Машинные модели уже широко распространены в сфере здравоохранения. Но у них есть так и не решенная проблема: они плохо генерализуются за пределами обучающих данных. Другими словами, даже минимальные отличия клинической практики от тех данных, что были использованы для обучения систем, способны сильно снизить точность модели.

Ситуация усугубляется тем, что «врачи и администраторы плохо подготовлены к отслеживанию и борьбе с такими проблемами, и недостаточный учет человеческого фактора при интеграции ИИ приводит к колебаниям между недоверием к системе (игнорированием ее) и избыточной уверенностью в ней (доверием даже тогда, когда она не права)...» Отсылка к человеческому фактору повторяет то, что было сказано в контексте применения ИИ в правосудии: человеческое невежество способно обратить во вред даже самую эффективную технологию.

Но и на этапе создания модели ошибки тоже возможны. А цена ошибки в сфере здравоохранения велика. «Неправильно обученный алгоритм может причинить больше вреда, чем пользы для подверженных риску пациентов.

Авторы не упускают случая в очередной раз напомнить читателю про опасности предубеждений, закрепленных в моделях. В качестве примера они приводят историю с американской ”Optum”, чей алгоритм сильно занижал уровень медицинских рисков для чернокожих пациентов по сравнению с белыми. Загвоздка была в том, что система использовала прогноз будущих медицинских расходов в качестве меры риска. А у чернокожего населения США они на $1,8 тыс. долларов в год ниже, чем у белых.

То есть оцените степень лицемерия: здравоохранение фактически тратит на негров существенно меньше денег, чем на белых — но виноват почему-то оказался алгоритм. Конечно, проще бороться со следствием, чем с причиной. И это не просто расхожая фраза: исправить алгоритм на самом деле оказалось очень легко.

Но это не останавливает пыл авторов. «...Индивиды, исключенные из изначальных датасетов, не получат адекватного внимания». Стоп, как это должно работать?! Эксперты не в курсе, что алгоритмы обучаются на ограниченной выборке — запихнуть в обучающий датасет всё население попросту невозможно? Более того, в медицинских применениях почти всё зависит от конкретного времени: потребности пациента за 10 лет до инсульта сильно отличаются от потребностей через 30 минут после, и даже к абсолютно здоровому человеку в 5-летнем возрасте медицина относится совсем по-иному, чем в 80-летнем. Добавим, что на ограниченных выборках проверяются и все виды классической терапии. В чем тогда заключается претензия ”AI100”?

Но это не всё. Еще большее удивление вызывает следующий пассаж. «...Потенциал [алгоритмов] по воспроизведению пристрастий означает, что любой прогресс, который они принесут для населения в целом — от диагностики до распределения ресурсов — может быть достигнут за счет наиболее уязвимых [групп]”.

Ну хорошо, распределение ресурсов еще можно представить как игру с нулевой суммой. Но всё остальное? И даже с ресурсами не все так однозначно — возможность ИИ расширить пул доступных ресурсов тоже нельзя сбрасывать со счетов.

И это мы еще не касались вопроса, насколько алгоритмы воспроизводят пристрастия лучше, чем человеческие системы. И действительно ли они более склонны обижать уязвимые слои населения — слои, которые стали уязвимыми исключительно по итогам работы человеческих институтов.

Мы уже упоминали про технологический детерминизм — а что насчет детерминизма институционального? Или авторы реально считают, что в человеческих институтах нет системных предубеждений, которые воспроизводят сами себя? Альтернативные варианты — это важная часть оценки любого риска. Увы, авторы ”AI100” напрочь игнорируют эту часть.

Выводы

Подведем итоги. Первая, и очень важная тема, которая объединяет почти все перечисленные выше риски — это то, что источником проблем является даже не столько сам ИИ, сколько работающие с ним люди. Те, кто не до конца понимает его возможности и ограничения, те, кто не умеет с ним работать, те, чьи наивные представления сильно расходятся с реальным состоянием дел. Пресловутый человеческий фактор оказывается самым слабым звеном при внедрении ИИ в практику.

И решения здесь лежат скорее не в плоскости улучшения ИИ, а в повышении ИИ-грамотности, образовательных усилиях и тщательном дизайне обращенной к пользователю части системы.

Второе наблюдение — эксперты придают огромнейшее значение вопросам справедливости. Едва ли не каждая тема насыщена упоминаниями о том, насколько алгоритмы пристрастны и насколько это опасно. Всё это ложится в русло восприятия прогресса в ИИ как игры с нулевой суммой (хотя прямо авторы это не утверждают): суммарная польза (или вред, поскольку глава исследует риски) несущественны; всё, на что способен ИИ — это угнетать уязвимые группы и возвышать за счет них привилегированные.

Такое пренебрежение общими эффектами в пользу особенностей их распределения выглядит странно как минимум на фоне того, что ИИ считается подрывной технологией, т. е. способной фундаментально изменить жизнь людей. Трудно согласиться с позицией, что нас не волнует, будем ли мы жить хорошо или плохо — главное, чтобы всем было одинаково хорошо или плохо...

При этом у меня сложилось впечатление, что эксперты довольно узко трактуют алгоритмические пристрастия, делая акцент на мейнстримных категориях — раса, пол, уровень дохода, наличие инвалидности. С одной стороны, сейчас действительно у маргинализованных групп этих категорий хватает проблем. Но, с другой, использование новых инструментов может повлечь за собой возникновение новых проблемных категорий, да и не все из существующих уязвимых групп получают внимание мейнстримных экспертов и медиа. В целом, немного перефразировав известное изречение, слова авторов ”AI100” об ИИ говорят нам больше об авторах ”AI100”, чем об ИИ.

Наконец, еще один момент — довольно скромный набор потенциальных рисков, предложенных экспертами. Без внимания остались некоторые вещи, где внимание было бы очень кстати. Подрывной характер технологии и весьма быстрое ее распространение означают, что крупные изменения затрагивают очень многие стороны нашей жизни.

Два направления хотелось бы отметить особо. Первое — боевое применение ИИ. ”AI100” упоминает его совсем мельком, в другой главе. Между тем, со времени публикации предыдущего отчета произошло эпохальное событие — впервые в истории человечества автономная машина выследила и убила людей. Технологии автономии стали настолько зрелыми и доступными, что в ближайшие пять лет нас ждет буквально «взрыв» количества развернутых боевых ИИ-систем.

Второе — это алгоритмизация систем принятия решений, проводимая коммерческими компаниями. Самые различные вещи, которые раньше были заботой людей — поиск романтического партнера, подбор лечения, отбор поступающих в учебные заведения — сейчас выполняется при помощи коммерческих алгоритмов. Их создатели преследуют коммерческие интересы — и рост влияния капитала в прежде "гуманитарных" сферах может создать опасные коллизии.

Не является индивидуальной инвестиционной рекомендацией | При копировании ссылка обязательна | Нашли ошибку - выделить и нажать Ctrl+Enter | Жалоба